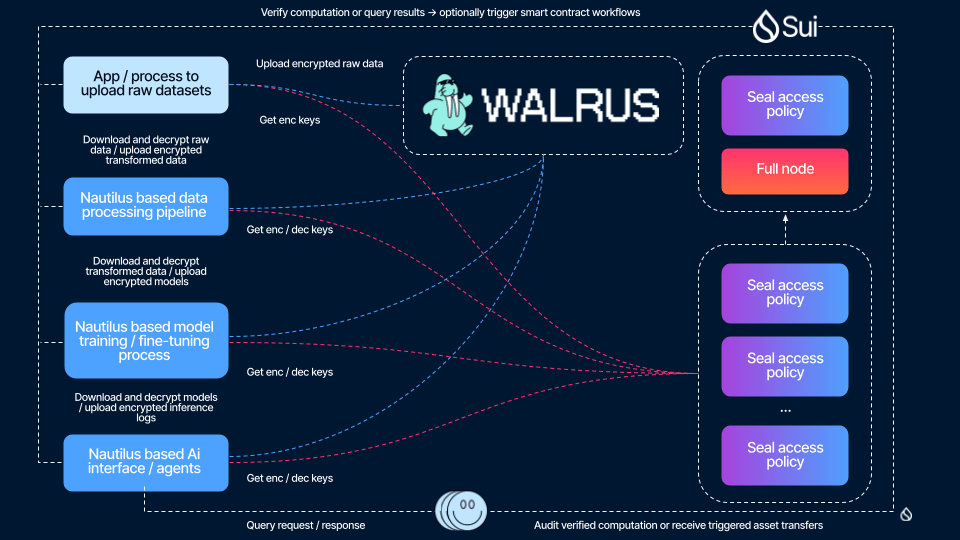

Construir agentes de IA en Sui a menudo genera dudas sobre el manejo de datos. El protocolo Walrus aborda estas cuestiones directamente al ofrecer almacenamiento verificable para conjuntos de datos y modelos. Este análisis profundo desmiente mitos comunes, mostrando cómo Walrus permite flujos de trabajo de IA reproducibles con utilidades de tokens WAL integradas.

Mitología 1: La IA onchain carece de integridad de datos

Los escépticos afirman que el almacenamiento en blockchain corrompe los datos de IA con el tiempo. Walrus rebate esto con compromisos criptográficos. Cada carga de blob genera un ID único y una prueba, verificables en Sui. Esto garantiza que los conjuntos de datos permanezcan intactos, vinculados directamente a pagos en WAL para una disponibilidad sostenida.

Hecho 1: Pruebas verificables en acción

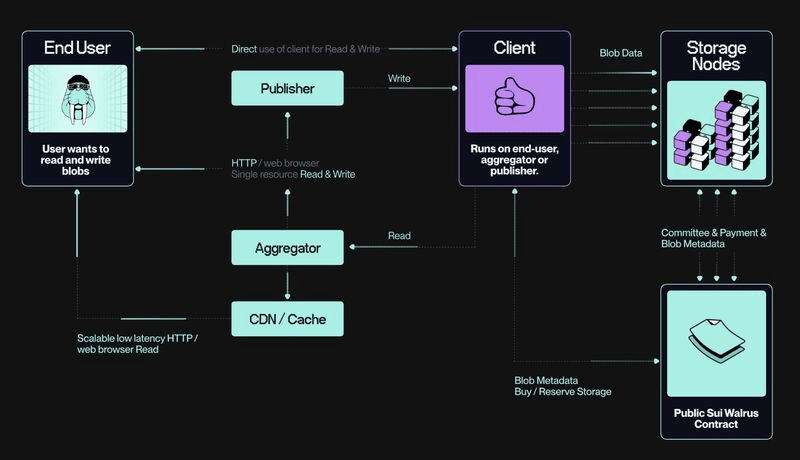

Walrus utiliza pruebas de disponibilidad para confirmar la integridad de los datos. Los nodos almacenan fragmentos codificados por erasure; los clientes realizan muestras para verificarlos. En Sui, los contratos inteligentes imponen estas pruebas, haciendo que las entradas de los agentes de IA sean reproducibles. Los tokens WAL recompensan a los nodos honestos y sancionan los fallos mediante quemas, según fuentes oficiales.

Mitología 2: La reproducibilidad sufre en entornos descentralizados

Las nubes centralizadas ofrecen una replicación sencilla, pero ¿y las descentralizadas? Muchos piensan que es caótico. Walrus estructura los datos como objetos programables en Sui, permitiendo a los agentes referirse a versiones exactas. Esto mantiene la consistencia del flujo de trabajo en cada ejecución.

Hecho 2: Datos programables para salidas repetibles

Gracias a la integración con Move, los blobs de Walrus se convierten en objetos con metadatos. Los agentes de IA los consultan para conjuntos de datos fijos, asegurando resultados idénticos. WAL facilita las tarifas de acceso, distribuidas a los apostadores para el mantenimiento de la red.

Mitología 3: Los flujos de trabajo fallan bajo escala

Se dice que las tareas de IA de alto volumen sobrecargan el almacenamiento onchain. El codificado RedStuff de Walrus distribuye la carga, permitiendo el soporte de enjambres de agentes sin cuellos de botella. Esto escala la reproducibilidad sin puntos de congestión centralizados.

Hecho 3: Codificación por eliminación para acceso duradero

RedStuff divide los datos en fragmentos basados en matrices, tolerando hasta un 1/3 de fallos de nodos. Los agentes los recuperan mediante cuórum, manteniendo los flujos de trabajo intactos. Las recompensas de WAL alinean el rendimiento del nodo con la fiabilidad del ecosistema.

Componentes clave del flujo de trabajo

- Anclaje de conjuntos de datos: Almacena los datos de entrenamiento de IA como blobs para identificadores verificables.

- Persistencia de modelos: Mantén los modelos de inferencia en Walrus para que el agente pueda recordarlos.

- Gestión de memoria: Usa blobs para el estado del agente, permitiendo la reproducibilidad de múltiples pasos.

- Infraestructura de pagos: WAL gestiona los períodos de almacenamiento y acceso.

Recorrido por el plano: Construcción de un flujo de trabajo de agente de IA

Aquí tienes una guía paso a paso para desplegar un agente de IA reproducible en Sui usando Walrus:

1. Preparar los datos: Formatea tu conjunto de datos de IA como un blob, asegurándote de que esté por debajo del límite de 1 GB por carga de Walrus.

2. Cargar en Walrus: Usa la CLI para almacenar el blob, especificando los períodos pagados en WAL; recibe un ID de blob.

3. Integrarse con Sui: Crear un objeto Move que vincule el ID del blob, añadiendo metadatos para comprobaciones de integridad.

4. Definir la lógica del agente: Escribe un contrato inteligente que haga referencia al blob para entradas, imponiendo la verificación de pruebas.

5. Ejecutar el flujo de trabajo: Disparar al agente para recuperar datos mediante las API de Walrus, procesarlos en transacciones de Sui.

6. Verificar la reproducibilidad: Realiza auditorías mediante muestras de pruebas, confirmando que los resultados coinciden con ejecuciones anteriores.

7. Gestionar incentivos: Pagar WAL por extensiones; los nodos ganan participaciones por mantener los datos.

Vínculos del ecosistema con la utilidad de WAL

Los flujos de trabajo de Walrus dependen de WAL para pagos y sanciones. Los usuarios apostan WAL para operar nodos, ganando de las tarifas de almacenamiento. Este ciclo apoya la escalabilidad de los agentes de IA dentro del ecosistema.

Riesgos y limitaciones

- La congestión de red en Sui podría retrasar la recuperación de blobs durante la actividad pico de agentes.

- La volatilidad de WAL afecta la previsibilidad de costos para el almacenamiento a largo plazo de conjuntos de datos.

- La muestra de pruebas requiere carga computacional, limitando agentes de muy baja potencia.

Walrus desmitifica a los agentes de IA en Sui al imponer integridad de datos y reproducibilidad. Los tokens WAL sustentan las recompensas, haciendo que los flujos de trabajo sean sostenibles. Este plano abre la automatización confiable.

¿De qué formas podrían los conjuntos de datos verificables transformar tus diseños de agentes de IA en Walrus?